诺奖级成果!高导热复合材料世界性难题迎来重大突破,连发多篇顶刊震动学术界!

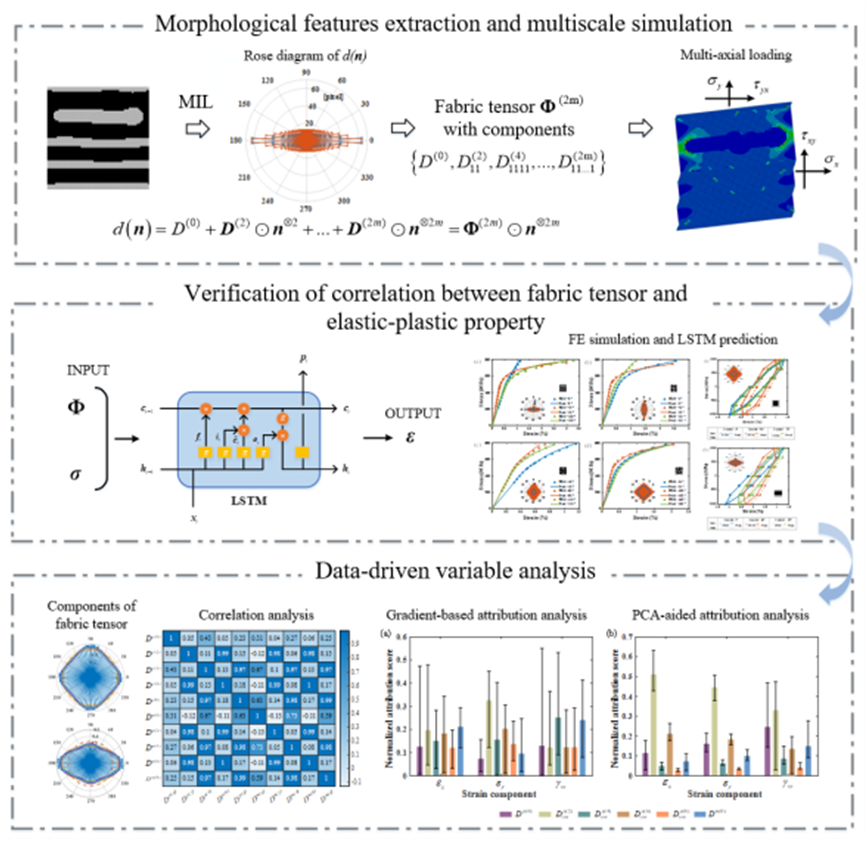

一、AI赋能复合材料智能设计与多尺度仿真

背景介绍

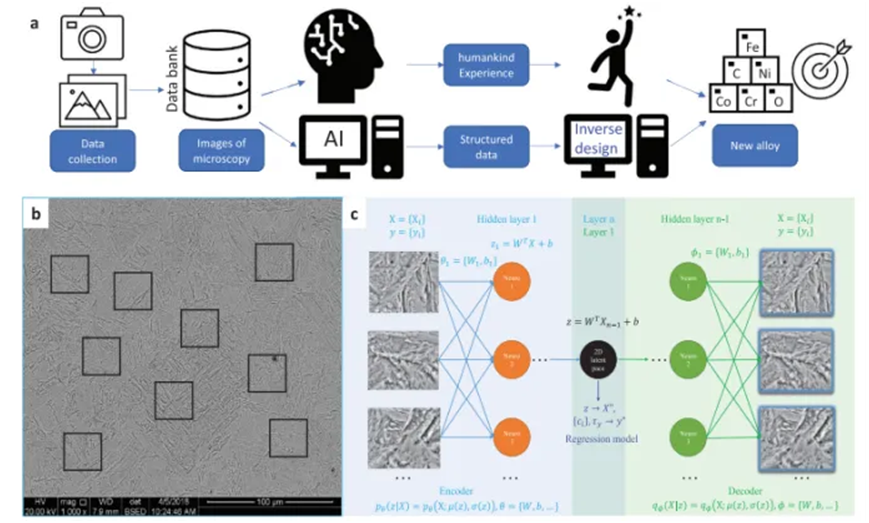

AI复合材料的研究背景源于传统复合材料研发范式正面临严峻挑战。复合材料的性能由无数相互耦合的变量(如纤维取向、铺层顺序、工艺参数等)共同决定,其“成分-结构-工艺-性能”关系极度复杂,像一个难以解析的“黑箱”,导致传统依赖物理模型和试错实验的方法不仅成本高昂、周期漫长,而且难以实现制造过程的精准质量控制、无损检测数据的高效解读以及长期服役性能的准确预测。与此同时,人工智能(AI)技术,尤其是机器学习和深度学习,因其强大的从高维非线性数据中学习规律的能力、处理海量信息的效率以及毫秒级的实时预测优势而迅猛发展。这促使研究者们将AI深度融入复合材料的设计、制造、检测与运维全生命周期,旨在通过数据驱动和智能赋能的新范式,解决上述核心痛点,实现逆向设计、工艺优化、自动无损评估和加速新材料发现,最终推动复合材料技术走向智能化、精准化和高效化,以满足航空航天等高端领域对高性能先进材料的迫切需求。

卷积神经网络与有限元复合材料损伤预测

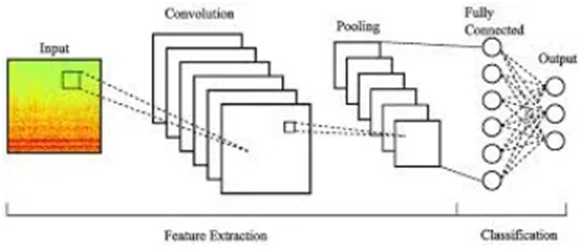

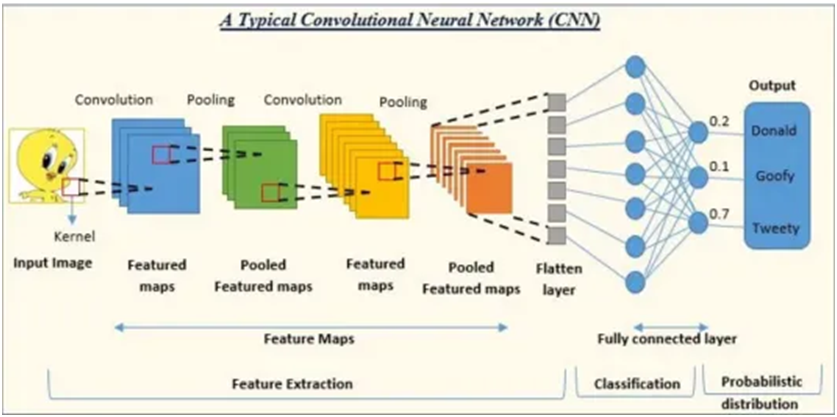

1. 神经网络与CNN核心原理(实操+代码)

(1) 感知机到卷积神经网络的演进路径

(2) 卷积层数学原理:参数共享与特征提取机制(3) 池化层与激活函数的作用机制

(4) 快速实操:手动实现简单卷积运算

图 CNN基础架构图

2. 图像分割网络架构基础 (实操+代码)

(1) 从分类到分割:FCN网络转换原理

(2) 编码器-解码器架构设计思想

(3) 转置卷积与上采样策略对比

(4) 代码演示:构建基础FCN分割网络

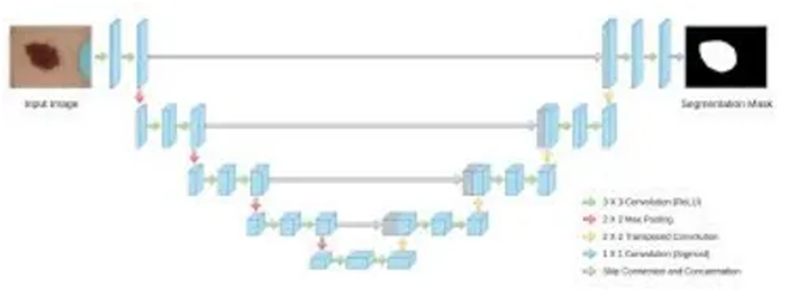

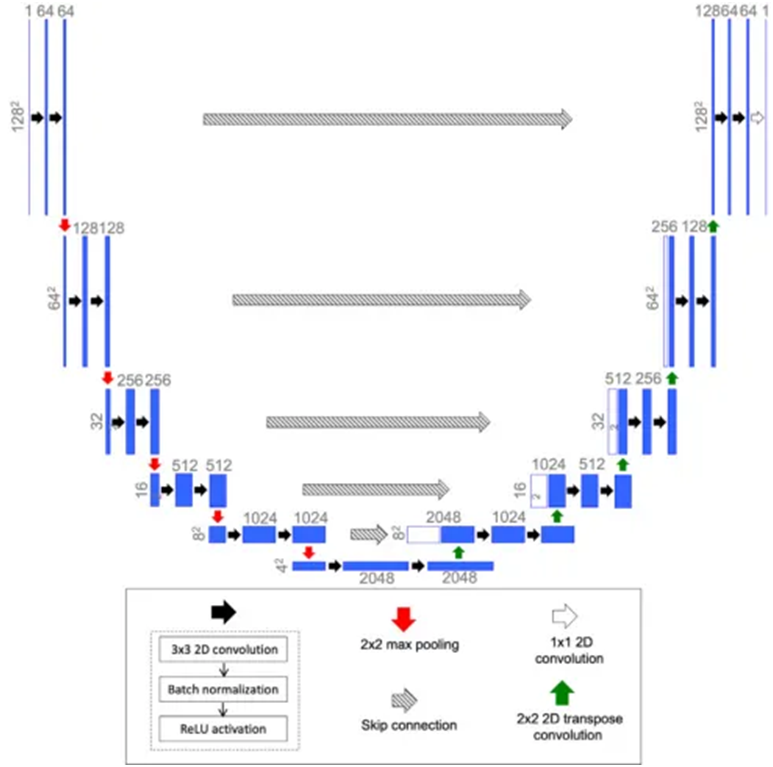

3. U-Net架构深度解析

(1) U-Net核心架构剖析 (实操+代码+演示)

(2) U-Net对称结构设计理念与点

(3) 跳跃连接(Skip Connection)的关键作用

(4) 特征图尺度变化与信息保持机制

核心实操:

完整U-Net网络架构构建

关键层级特征图变化分析

图 U-Net完整架构与信息流向图

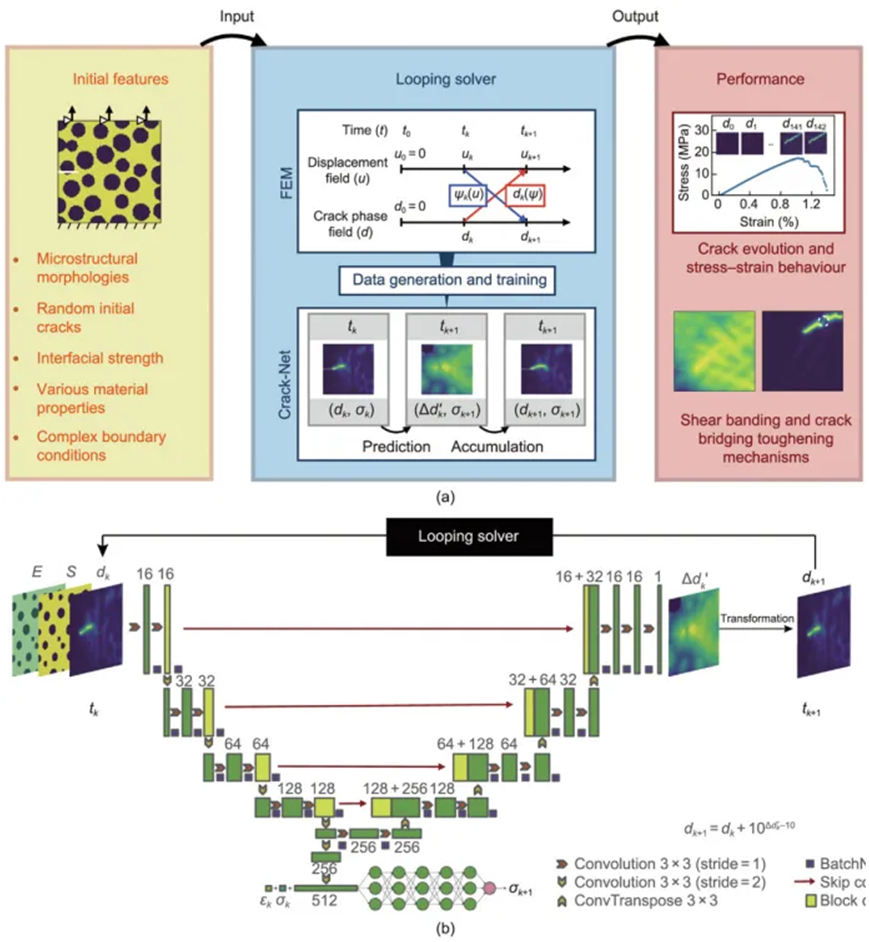

有限元与相场方法基础及Crack-Net架构核心技术

1. 有限元方法相场损伤理论基础 (实操)

(1) 损伤变量d的物理意义与数学描述

(2) 相场理论:从Cahn-Hilliard到裂纹演化实操实现:相场裂纹演化

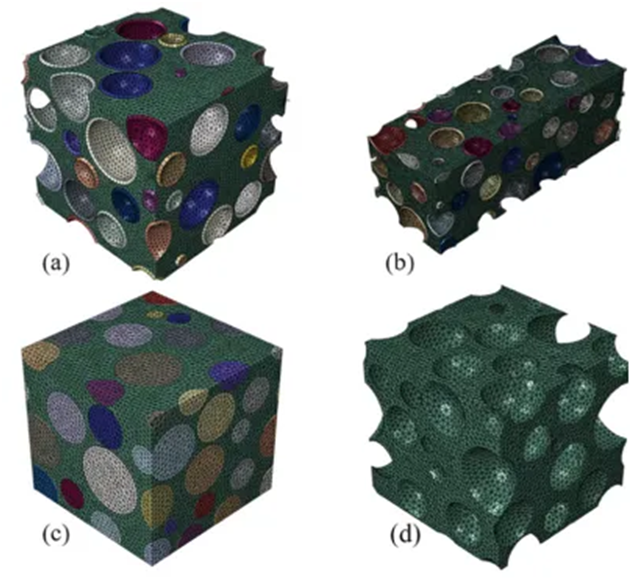

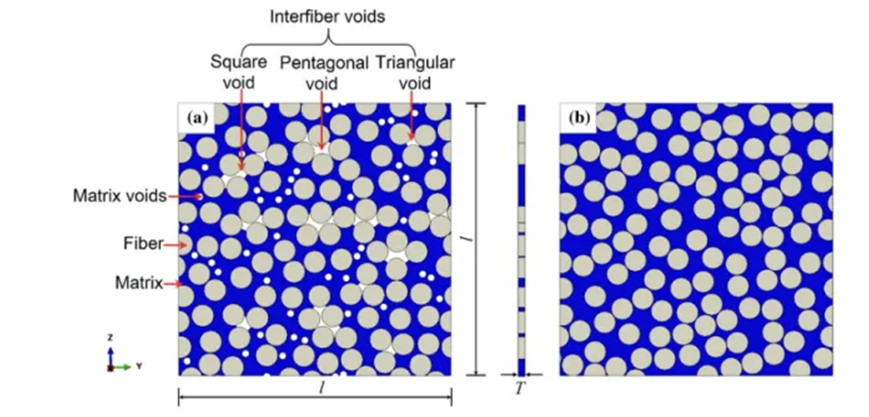

2. 复合材料建模与传统方法

(1) 复合材料微观结构建模Abaqus中裂纹扩展模拟 (实操)

(2) 代表性体积元(RVE)设计与周期边界条件

(3) 多相材料界面建模策略

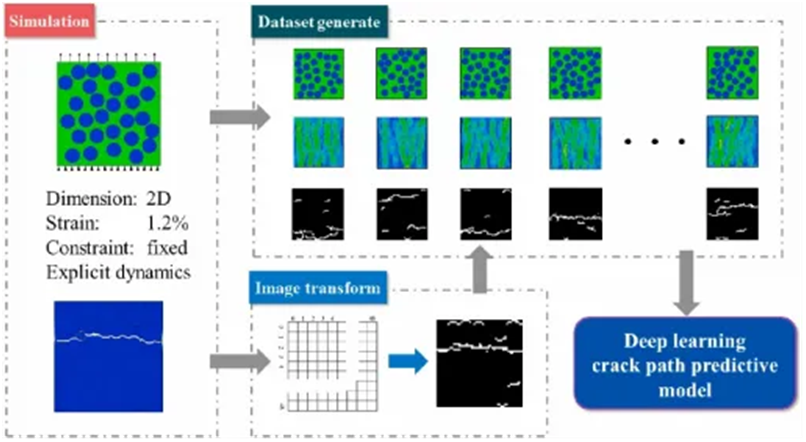

3. Crack-Net架构核心技术

(1) 从U-Net到Crack-Net的演进 (实操+代码+演示)

(2) Crack-Net整体架构设计理念分析

(3) 多任务学习:应力预测+相场预测联合训练

图:Crack-Net 框架

差分深度学习复合材料应力预测

背景:从编码器-解码器基础架构出发,深入到差分神经网络(DiNN)在复合材料应力预测中的前沿应用。

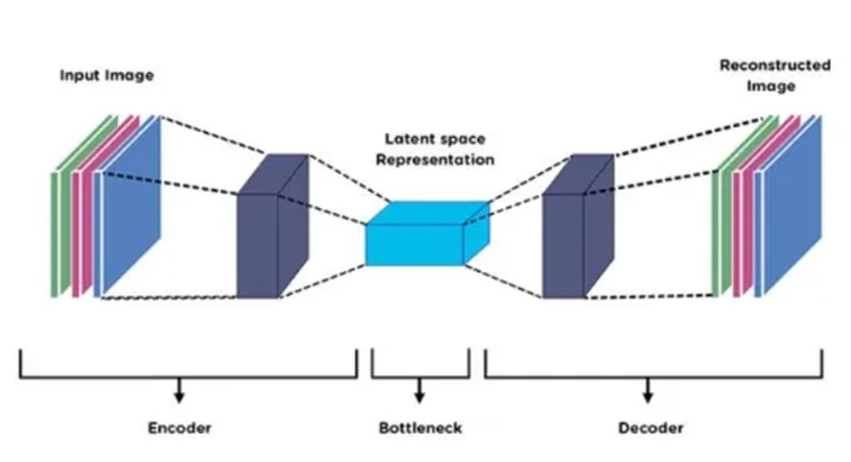

编码器-解码器架构基础理论

1. CNN与编码器-解码器核心原理 (实操+代码)(1) 卷积神经网络特征提取机制与参数共享

(2) 编码器-解码器对称架构设计思想

(3) 特征降维与重构的数学原理

(4) 快速实操:构建基础编码器-解码器网络

图 编码器-解码器基础架构图

2. 图像到图像转换网络基础 (实操+代码)

(1) 从分类任务到回归预测的网络适配

(2) 空间信息保持与特征图尺度变换

(3) 跳跃连接在空间预测中的作用机制

(4) 代码演示:实现简单的图像到图像转换网络

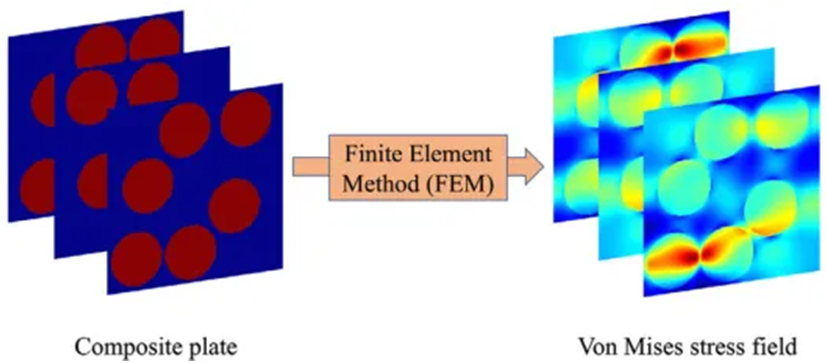

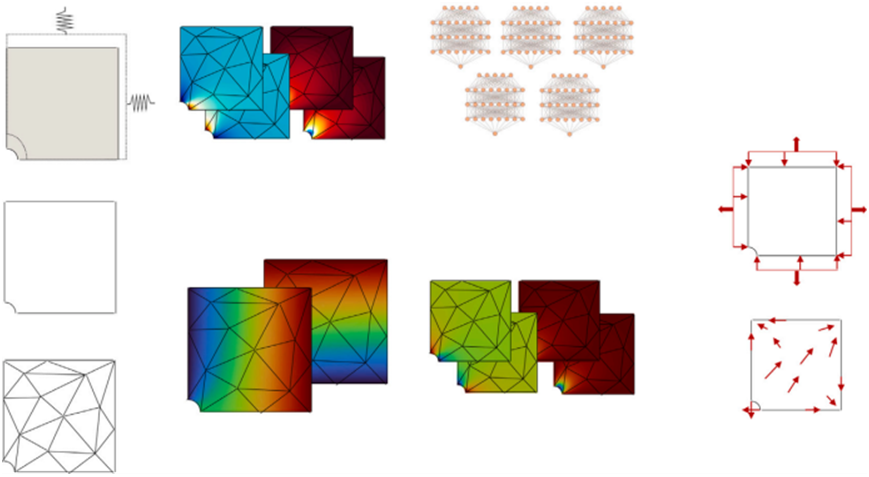

3. 有限元应力分析基础理论 (实操+代码)

(1) 线性弹性力学基本方程与边界条件

(2) 网格划分与应力场数值求解原理

(3) von Mises应力计算与物理意义

(4) 快速实操:简单结构的FEA应力计算

4. 重心坐标插值与数据标准化 (实操+代码+演示)(1) 三角网格到规则网格的插值挑战

(2) 重心坐标系统的数学原理与稳定性优势

(3) 笛卡尔映射数据预处理策略

(4) 核心实操:重心坐标插值算法实现

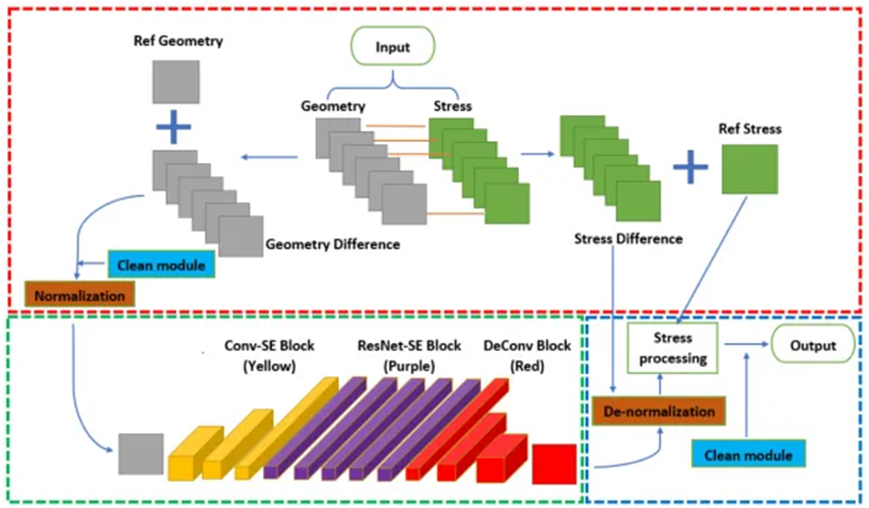

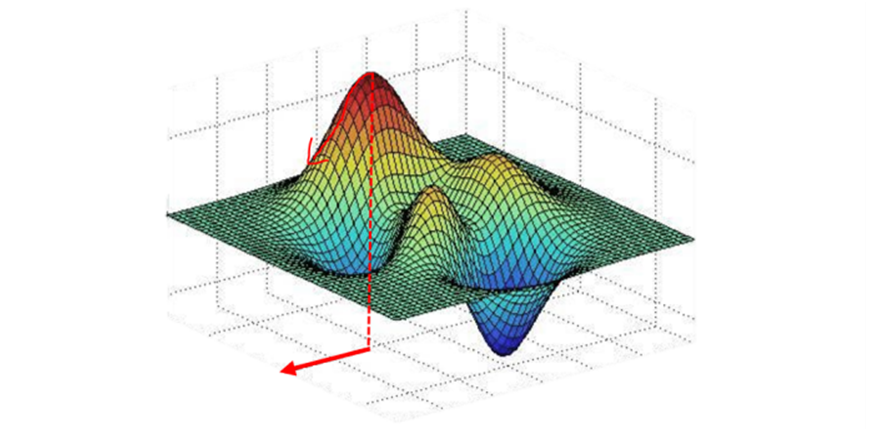

差分神经网络(DiNN)核心技术

1. 从传统方法到差分学习实操(实操+代码+演示)(1) 传统端到端预测的局限性分析

(2) 差分学习思想:参考模型与差分训练策略

(3) DiNN三模块架构:样本处理+编码解码+应力预测

图 DiNN完整架构与点图

2. SE注意力机制与ResNet融合技术 (实操+代码)(1) Squeeze-and-Excitation块的通道注意力机制

(2) Conv-SE与ResNet-SE块的协同工作原理

(3) 特征重标定与高级特征提取策略

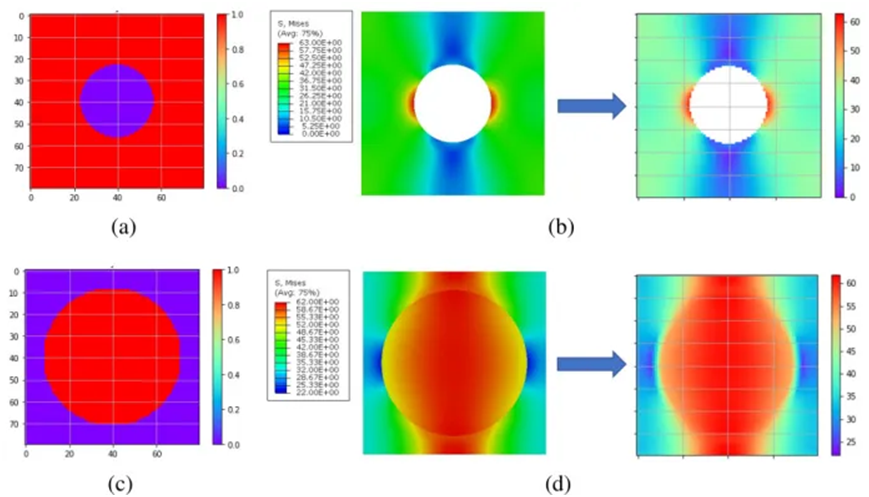

3. 复合材料应力预测完整流程 (实操+代码+演示)(1) 典型复合材料模型的应力预测实现

(2) 体积分数随机性vs空间随机性的处理策略

(3) 应力集中区域的精确预测技术

(4) 工程案例:

纤维增强复合材料应力场预测

颗粒增强复合材料的完整建模流程

图 不同复合材料的应力预测结果对比

复合材料应力场预测

背景

从卷积神经网络基础出发,深入到U-Net架构在纤维增强复合材料应力场预测中的应用。

卷积神经网络基础理论深化

1. 卷积神经网络高级特征提取机制 (实操+代码)

1.1 卷积核设计原理:3×3卷积的参数效率与感受野分析

1.2 特征图降维与信息保持的数学平衡机制

1.3 批量归一化在训练稳定性中的关键作用

1.4 快速实操:构建多层CNN进行复杂模式识

图 多层CNN特征提取机制图

图 多层CNN特征提取机制图

2 U-Net编码器-解码器架构核心机制 (实操+代码+演示)

2.1 编码器路径:逐层特征抽象与空间信息压缩2.2 解码器路径:特征重建与空间分辨率恢复机制2.3 跳跃连接的数学原理:高层语义与低层细节的融合

不同尺度特征图的concat操作与信息传递

详细实操:

完整U-Net网络的分层构建与参数分析

跳跃连接对预测精度影响的实验验证

图 U-Net详细架构与跳跃连接机制图

有限元基础与复合材料应力分析

1. 应力云图的后处理与数据提取方法

2 数据预处理与图像标准化 (实操+代码)

2.1 二值化微观结构图像的生成与处理

2.2 应力场数据的归一化与标准化策略

2.3 图像翻转数据增强的物理合理性分析

3 微观结构到应力场的深度映射 (实操+代码+演示)

3.1二值化纤维分布图像作为网络输入的编码策略3.2连续应力场作为网络输出的解码机制

图 微观结构-应力场映射网络架构图

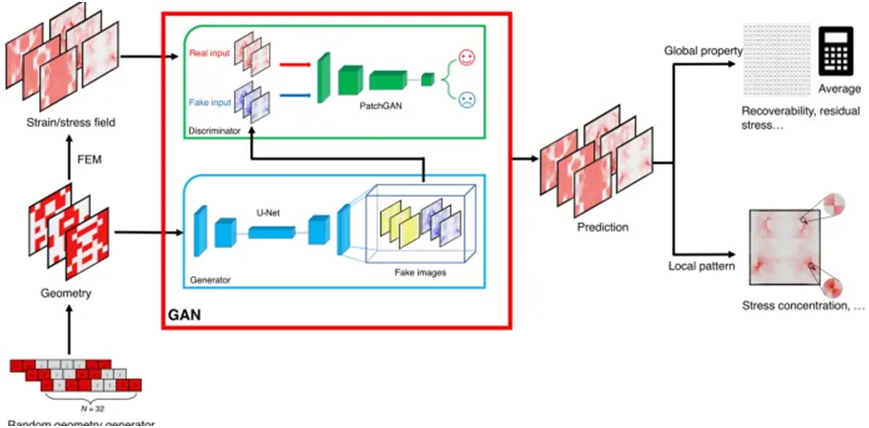

生成对抗网络复合材料场预测

背景:从生成对抗网络基础出发,深入到几何-场映射在复合材料设计中的前沿应用。

生成对抗网络基础理论

1. 生成对抗网络(GAN)核心原理 (实操+代码)

(1) 博弈论框架:生成器与判别器的对抗训练机制(2) Nash均衡在神经网络训练中的数学表示

(3) 条件生成对抗网络(cGAN)的约束机制

(4) 快速实操:构建基础GAN进行图像生成

图 GAN基础架构与博弈论框架图

l U-Net与PatchGAN架构深度解析 (实操+代码)

U-Net编码器-解码器对称结构设计理念

跳跃连接在空间信息保持中的关键作用PatchGAN局部判别策略vs全局判别的优势

代码演示:U-Net在图像分割中的应用实现

2. 有限元应力场计算基础 (实操+代码)

(1) 连续介质力学基本方程与本构关系

(2) 压缩载荷下的边界条件设置与求解策略

(3) von Mises应力场的物理意义与计算方法

(4) 快速实操:Abaqus中复合材料应力场计算

3. 复合材料微观结构建模 (实操+代码+演示)

(1) 双相材料的力学参数对比

(2) 载荷-卸载循环的残余应力分析

核心实操:材料参数对应力场分布的影响分析

图 复合材料微观结构

几何-场映射核心技术

1. 从传统仿真到智能预测的进阶 (实操+代码+演示)

(1) 图像到图像转换的深度学习范式

(2) 几何约束作为条件输入的网络设计

(3) 物理场信息的完整性保持策略

图 复合材料几何GAN框架

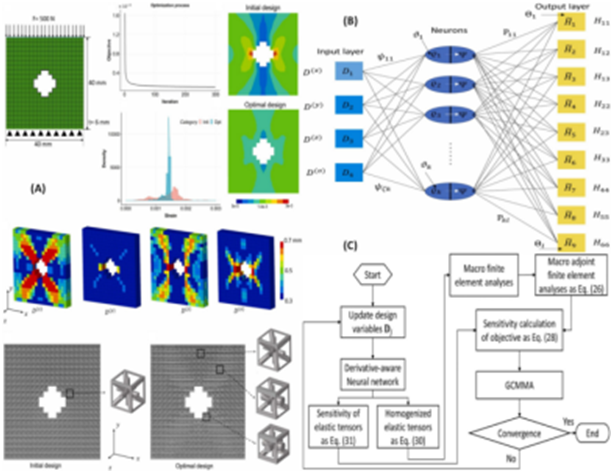

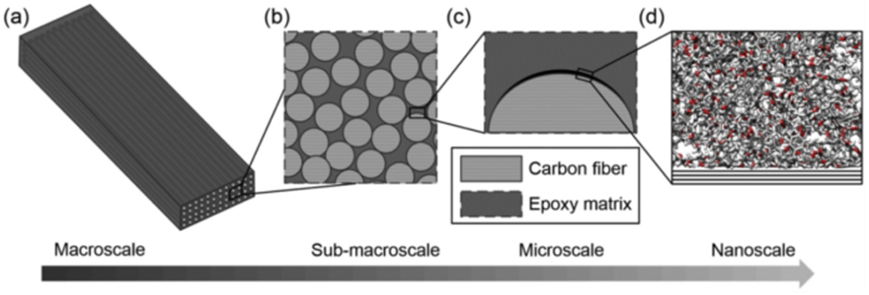

多尺度复合材料性能预测与智能材料设计

复合材料多尺度性能预测理论

1. 复合材料多尺度性能关联机制 (实操+代码)

(1) 纤维-基体-界面三相复合材料微观结构表征

(2) 复合材料RVE设计原则:纤维体积分数、分布模式、界面性质

(3) 均匀化理论在复合材料等效性能预测中的应用

(4) 快速实操:典型复合材料RVE的参数化建模与性能预测

2. 复合材料损伤机制与FE²耦合分析 (实操+代码)(1) 复合材料典型失效模式:纤维断裂、基体开裂、界面脱粘

(2) 宏观加载下微观损伤演化的多尺度映射关系

(3) 渐进损伤分析与最终失效强度预测

(4) 代码演示:复合材料损伤演化的FE²方法实现

图 复合材料多尺度损伤演化机制图

复合材料智能设计与性能优化

3. 复合材料UMAT智能本构模型开发 (实操+代码+演示)

(1) 复合材料各向异性弹性本构的UMAT实现

(2) 损伤演化方程与神经网络代理模型集成

(3) 复合材料非线性本构关系的AI加速求解

(4) 核心实操:复合材料智能UMAT子程序编写与验证

4. 神经网络驱动的复合材料性能预测系统 (实操+代码+演示)

(1) 复合材料微观结构图像到宏观性能的端到端预测

(2) 纤维取向、体积分数对复合材料强度/刚度的影响预测

(3) 复合材料疲劳寿命与损伤容限的智能评估

(4) 详细分析:

训练数据生成:不同复合材料体系的性能数据采集

多任务学习:同时预测弹性模量、强度、韧性等多个性能指标

图 复合材料性能预测神经网络架构图

二、人工智能材料疲劳分析与断裂力学

机器学习基础与疲劳断裂力学应用

1.1 机器学习概述

1.1.1 常见机器学习方法

·人工神经网络(ANN)

·支持向量回归(SVR)

·随机森林(RF)

·高斯过程回归(GPR)

1.1.2 工程材料科学应用前景

·材料性能预测典型场景

·跨尺度建模中的算法选择

1.2 神经网络核心技术

1.2.1 基础架构解析·神经元数学模型与激活函数对比·前馈网络信息传递机制

1.2.2 典型模型分类

·全连接网络(ANN)的局限性

·卷积网络(CNN)空间特征提取

·递归网络(RNN)时序数据处理

1.3 疲劳断裂分析智能化

1.3.1 关键影响因素体系

·应力幅值/平均应力效应

·表面状态/环境介质作用

1.3.2 寿命预测模型演进

·物理驱动模型:Paris定律扩展

·数据驱动模型:裂纹扩展速率预测

1.4 718合金疲劳预测实战

1.4.1 数据工程构建

·多源实验数据融合方法

·特征工程与标准化处理

1.4.2 模型训练与验证

·ANN/SVR/GPR/RF并行实现

·交叉验证与超参数优化

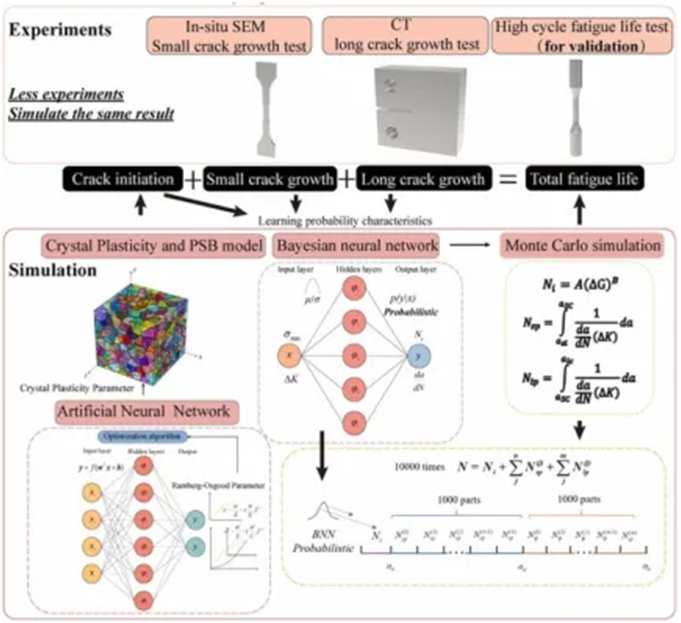

机器学习驱动的疲劳裂纹多尺度分析与寿命预测

2.1裂纹多尺度分析技术

2.1.1跨尺度关联方法

·微观位错演化至宏观裂纹扩展的跨尺度建模

·晶界效应与裂纹偏转的机器学习表征

2.1.2损伤力学基础

·裂纹萌生与短裂纹扩展的损伤阈值判定

2.2智能寿命预测前沿技术

2.2.1超声-Bayes融合方法

·超声信号特征提取与损伤指标构建

·贝叶斯概率框架下的实时寿命更新策略

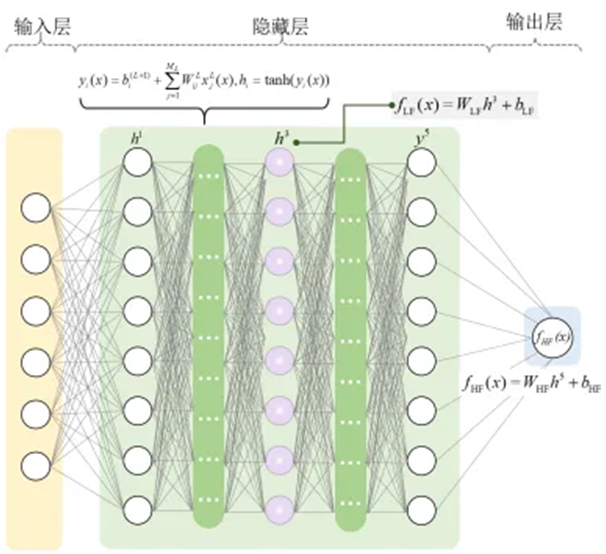

2.2.2多尺度数据驱动框架

·晶体塑性模型与ANN模型

·微结构-寿命关联的贝叶斯网络架构

2.3奥氏体不锈钢低周疲劳实战

2.3.1数据工程体系

·多源异构数据融合

·材料特征编码

2.3.2混合机器学习建模

·CART决策树的关键特征筛选逻辑

·XGBoost-ANN集成模型架构

2.3.3 工业验证方案

·特征重要性排序的可视化呈现

·预测误差的微观机理溯源

机器学习赋能的金属断裂表面智能分析

3.1 金属断裂理论体系

3.1.1 断裂力学基础框架

·线弹性/弹塑性断裂力学理论边界

·应力强度因子K与J应用场景

3.1.2 裂纹扩展准则

·Paris定律的疲劳裂纹扩展模型

·基于能量法的R曲线评估体系

3.1.3 损伤演化理论

·细观损伤力学的裂纹萌生阈值

·孔洞聚合模型的数值实现路径

3.2. 智能分析技术前沿

3.2.1 机器学习模型架构

·物理信息神经网络(PINN)的断裂准则嵌入

·图神经网络(GNN)的晶界裂纹预测

3.2.2 混合建模策略

·有限元-深度学习耦合仿真流程

·多尺度损伤演化的迁移学习框架

3.3 断裂表面定量分析实战

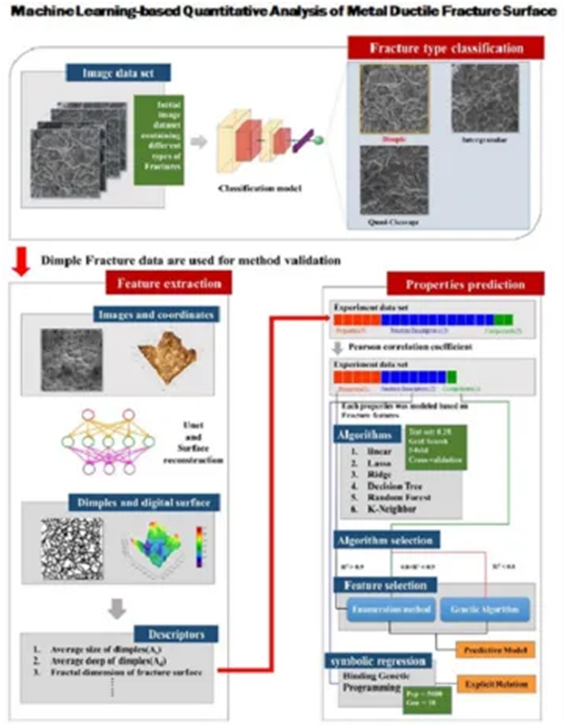

3.3.1 断裂形貌智能分类

·CNN特征提取网络设计

·沿晶/准解理/韧窝的微结构特征库构建

3.3.2 力学性能预测

·断裂韧性的回归预测模型

·断面收缩率的贝叶斯优化方法

3.3.3 工业验证方案

·预测结果的可视化误差分析

腐蚀疲劳与复合材料寿命预测

4.1 腐蚀疲劳机理与智能识别

4.1.1 腐蚀-疲劳耦合机制

·电化学腐蚀加速裂纹萌生的相场模拟

·应力腐蚀开裂(SCC)的跨尺度表征

4.1.2 焊件缺陷智能检测

·基于ResNet50的腐蚀疲劳裂纹分类

·声发射信号与X射线数据的多模态融合

4.2 复合材料损伤理论

4.2.1 微观损伤演化

·纤维断裂/基体开裂/界面脱层的竞争机制

·损伤热力学与熵产率关联模型

4.2.2 多尺度分析方法

·跨尺度损伤传递的图神经网络构建

4.3 智能预测系统

4.3.1 物理引导的深度学习框架

·裂纹扩展路径预测的机器学习架构

·本构约束的损失函数设计

4.3.2 多模态数据工程μCT扫描数据的语义分割处理

极端环境下的金属疲劳智能预测体系

5.1 极端工况损伤机理

5.1.1 高温疲劳-蠕变耦合效应

·位错攀移主导的蠕变损伤演化

·氧化加速裂纹扩展的跨尺度模型

5.1.2 物理信息神经网络架构

·蠕变-疲劳交互作用的损失函数设计

5.2 数据增强工程

5.2.1 小样本扩充技术

·基于Wasserstein GAN的微观结构生成

·高斯混合模型的工况参数插值

5.2.2 多尺度数据融合

·晶界滑移特征的最近邻插值优化

5.3 多尺度模拟前沿

5.3.1 损伤分析方法革新

·相场-晶体塑性耦合模型

5.3.2 工业验证案例

·镍基合金的蠕变疲劳预测

·误差补偿的迁移学习策略

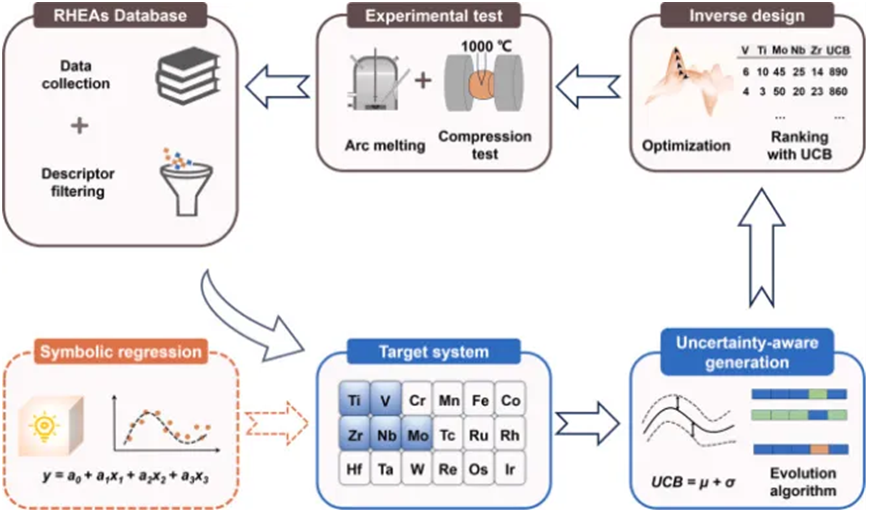

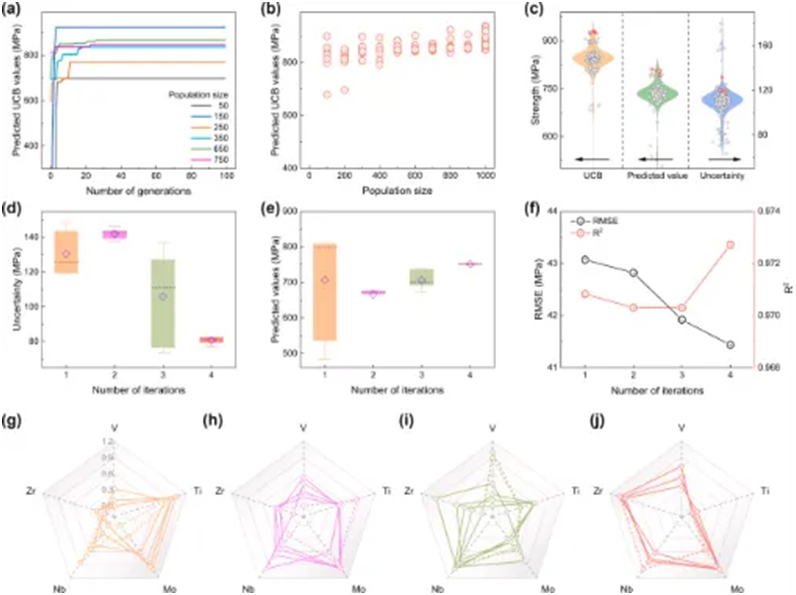

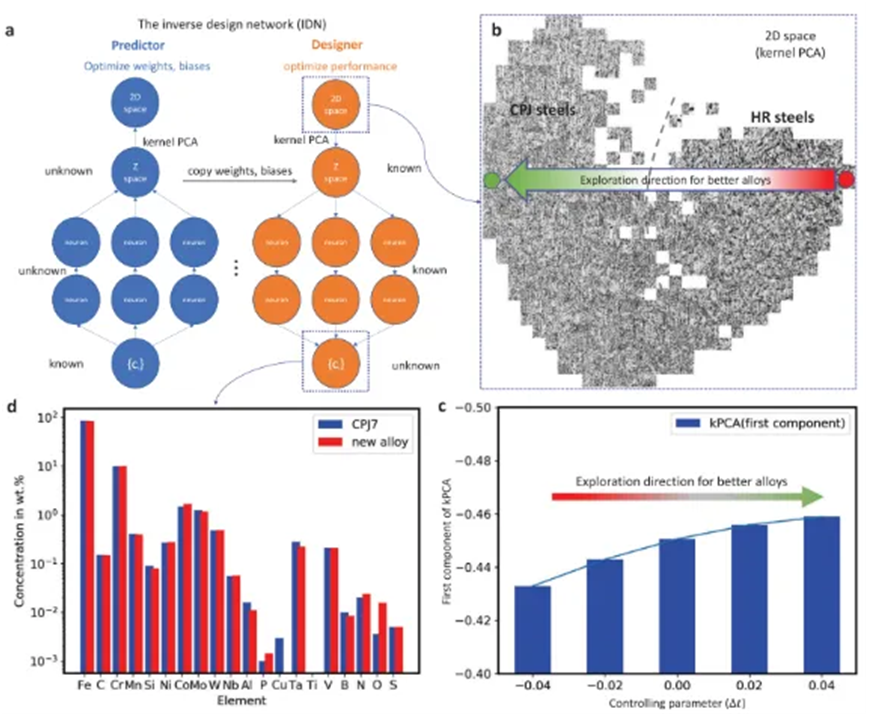

三、机器学习合金设计

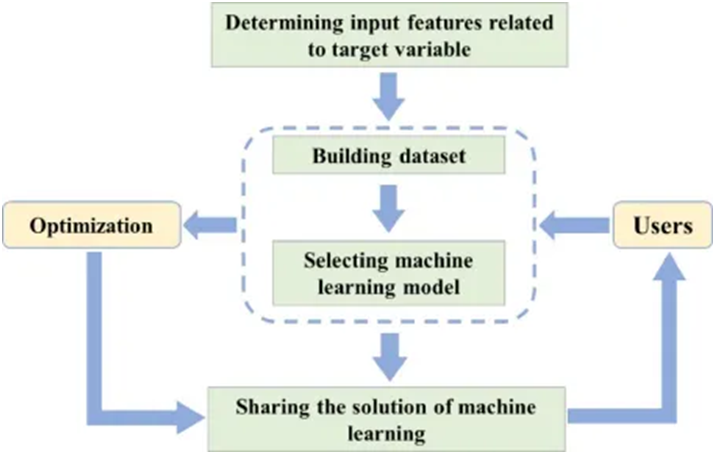

机器学习在合金设计领域的应用及其发展现状

1 基础导论:

目标、合金设计痛点与ML解决路径

领域发展史:从经验设计→CALPHAD→ML的范式演变

核心应用场景:成分优化/相预测/性能映射/逆向设计案例

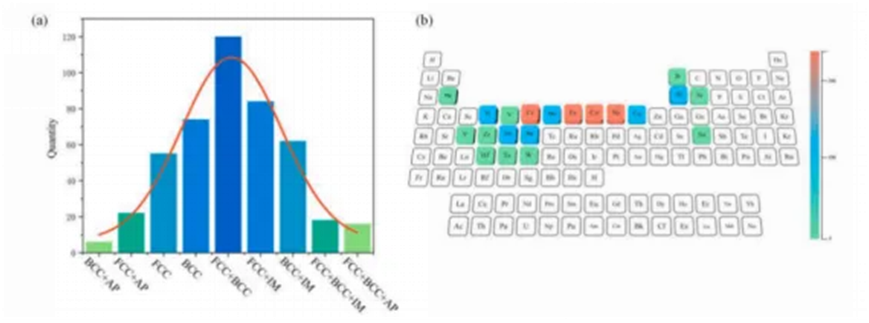

2 数据基石

数据来源: Materials Project/ICSD/OQMD数据库实战检索

特征工程: 原子半径/电负性/价电子数等描述符构建

数据清洗: 缺失值处理/异常值检测/标准化演示

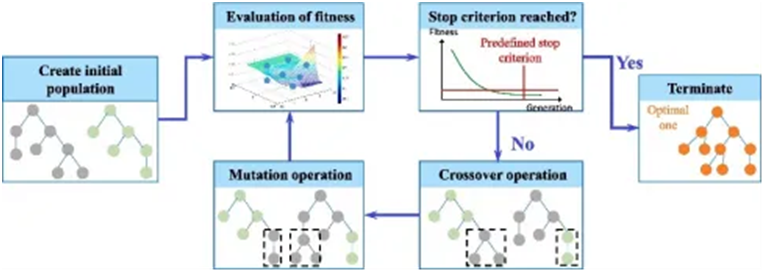

3. 算法全景

监督学习: 回归 vs 分类任务在合金中的典型模型

无监督学习 :聚类分析发现合金家族(PCA+t-SNE可视化)

强化学习:动态成分优化框架概念解析

4挑战与前沿

数据瓶颈: 小样本学习/迁移学习解决方案

可解释性: SHAP值分析高熵合金性能主导因素

趋势讨论: 生成式模型/多尺度建模最新论文解读

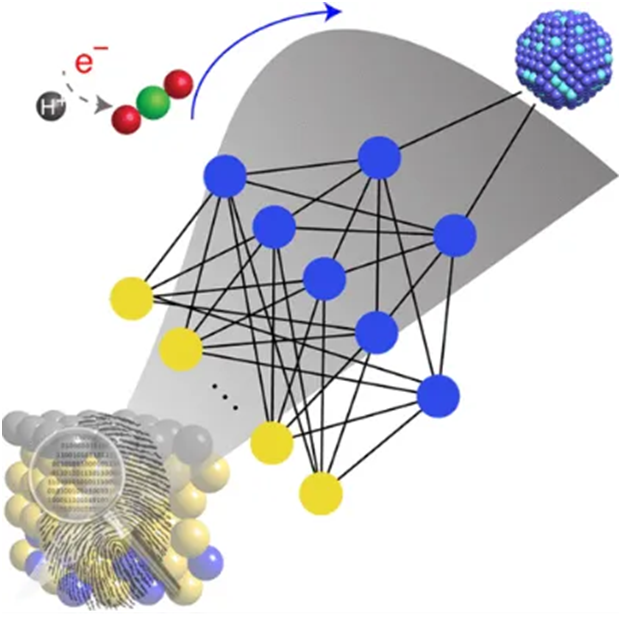

基于机器学习合金的成分-性能模型实战

各种合金系元素配比及其服役性能(力学性能、化学性能等),利用机器学习预测、解释合金成分与性能间的关系。

利用机器学习模型研究合金成分与力学性能、化学性能等之间的关系,预测与解释不同合金成分配比下的服役性能,以及不同合金成分对服役性能的影响。

利用机器学习模型预测不同合金成分下的服役性能

1.建立数据库的方法

2.利用不同的机器学习模型,建立合金成分与服役性能之间关系,预测不同合金成分配比下的服役性能(代码讲解与运行)

大节 | 小节 | 内容详情 |

2.1 建模基础 | 2.1.1 问题定义 | 成分→性能预测任务拆解 |

2.1.2 特征构造 | Magpie库自动生成元素特征 + 交互项衍生 | |

2.1.2 特征构造 | 多元线性回归与决策树快速验证 | |

2.2 进阶模型 | 2.2.1 集成方法 | 随机森林优化关键超参数 |

2.2.2 支持向量机 | 核函数选择与网格搜索(RBF vs Poly) | |

2.2.3 神经网络 | 3层MLP实现与Dropout防过拟合 | |

2.3 模型评估 | 2.3.1 验证策略 | |

2.3.2 评价指标 | MAE/RMSE/R² 针对连续变量解读 | |

2.3.3 误差分析 | 残差图定位系统性偏差样本 | |

2.4 优化部署 | 2.4.1 超参调优 | Bayesian Optimization库自动搜索 |

2.4.2 特征选择 | RFECV递归特征消除实战 | |

2.4.3 轻量化部署 | lask封装模型为API调用演示 |

基于机器学习合金的微观组织-力学性能预测实战

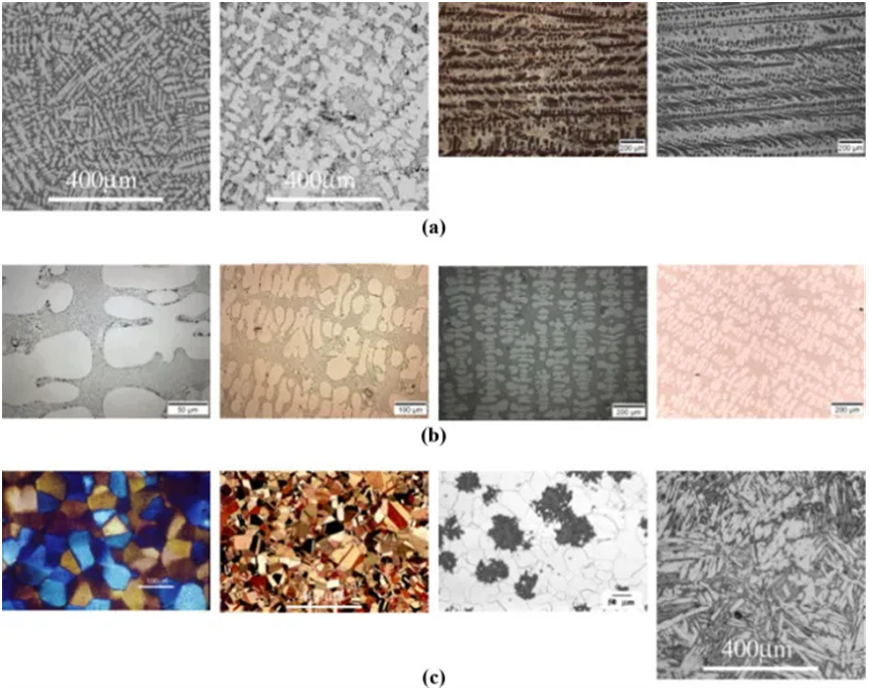

不同合金系的结构特点,包括微观结构,介观结构与宏观结构,利用机器学习研究多尺度结构与力学性能之间的关系。

利用机器学习研究合金微观组织结构与力学性能的关系

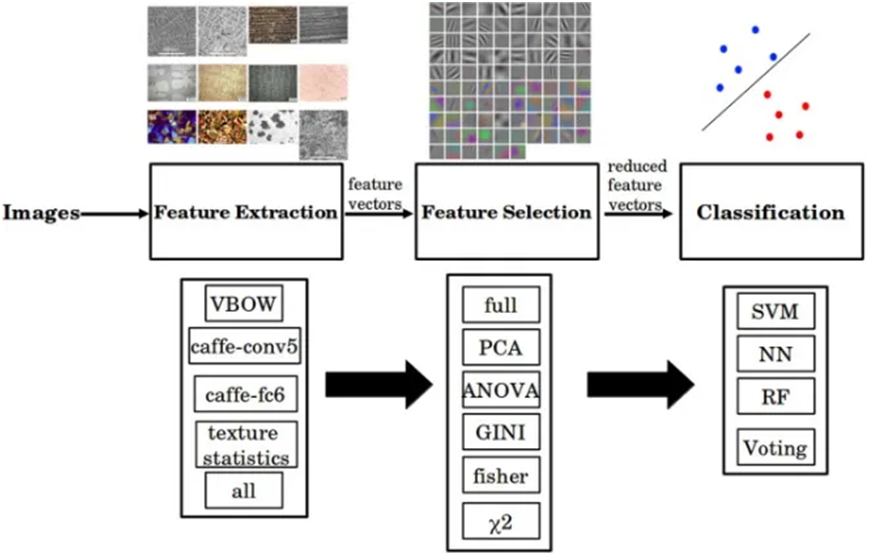

1.微观组织图片特征提取与筛选,建立数据库

2.利用不同的机器学习模型,建立微观组织与力学性能之间关系,预测不同合金组织下的服役性能(代码讲解与运行)

案例:GBDT预测高温合金γ'相尺寸对强度影响实战

大节 | 小节 | 内容详情 |

3.1 数据表征 | 3.1.1 图像获取 | SEM/EBSD/TEM数据格式与预处理 |

3.1.2 特征提取 | 晶粒尺寸/相比例/取向差统计方法 | |

3.1.3 图神经网络 | 晶界网络拓扑结构表征(PyG初步) | |

3.2 传统方法 | 3.2.1 物理模型 | |

3.2.2 经典ML | SVM预测屈服强度 | |

3.2.3 特征融合 | 成分+组织特征联合输入提升精度 | |

3.3 深度学习 | 3.3.1 CNN架构 | U-Net分割多相组织(PyTorch实现) |

3.3.2 迁移学习 | ResNet微调预测疲劳寿命 | |

3.3.3 多任务学习 | 同步预测强度/延伸率 |

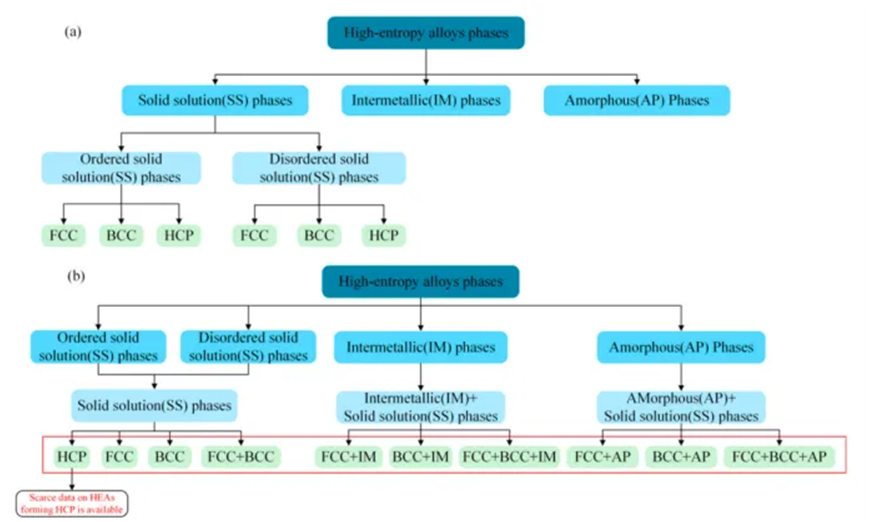

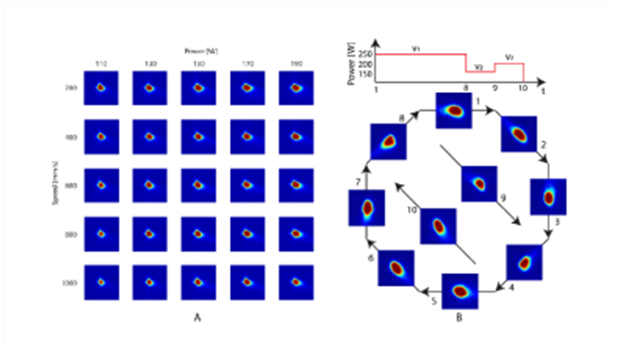

基于机器学习利用成分进行合金相场预测实战

常见的生成式AI:VAE, GAN以及他们的衍生模型的基本原理,介绍生成式AI在合金设计中的应用,如生成微观组织,对组织进行分类与识别等。

利用GAN来生成微观组织结构图片

利用GAN学习工艺参数、合金成分与微观组织之间的关系

1.代码讲解

2.利用GAN生成熔池图片

3.生成图片质量评估

案例:基于GAN的指定成分生成高熵合金显微组织

大节 | 小节 | 内容详情 |

4.1 相场基础 | 4.1.1 物理原理 | Cahn-Hilliard方程与自由能泛函 |

4.1.2 数值模拟 | FiPy库相场模拟演示(沉淀相粗化) | |

4.1.3 计算瓶颈 | 传统模拟耗时问题引入ML加速需求 | |

4.2 替代模型 | 4.2.1 数据生成 | 参数化扫描构建相场数据集 |

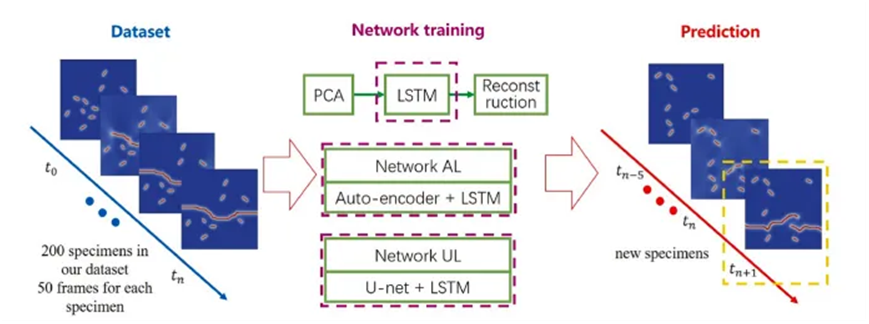

4.2.2 LSTM预测 | 时间序列预测相演化路径 | |

4.3 前沿方法 | 4.3.1 生成对抗网络 | GAN生成微观组织演化序列 |

4.3.2 图卷积网络 | 预测多晶体系晶界迁移 | |

4.3.3 主动学习 | 自适应采样减少模拟次数 |

基于机器学习的合金微观组织解析实战

利用机器学习来自动化或增强对材料微观组织图像(如金相、扫描电镜、透射电镜等)的分析和理解过程。

项目实践利用机器学习模型对微观组织进行识别

案例:基于CNN的高温合金相分割

大节 | 小节 | 内容详情 |

5.1 图像解析 | 5.1.1 分割进阶 | Mask R-CNN实例分割析出相 |

5.1.2 3D重构 | 层扫序列重建三维组织(Tomopy库) | |

5.2 生成设计 | 5.2.1 VAE基础 | 变分自编码器压缩组织特征空间 |

5.2.2 cGAN应用 | 条件生成目标显微组织(指定晶粒尺寸) | |

5.3 逆向优化 | 5.3.1 贝叶斯优化 | 搜索最佳工艺参数实现目标组织 |

5.3.2 强化学习 |

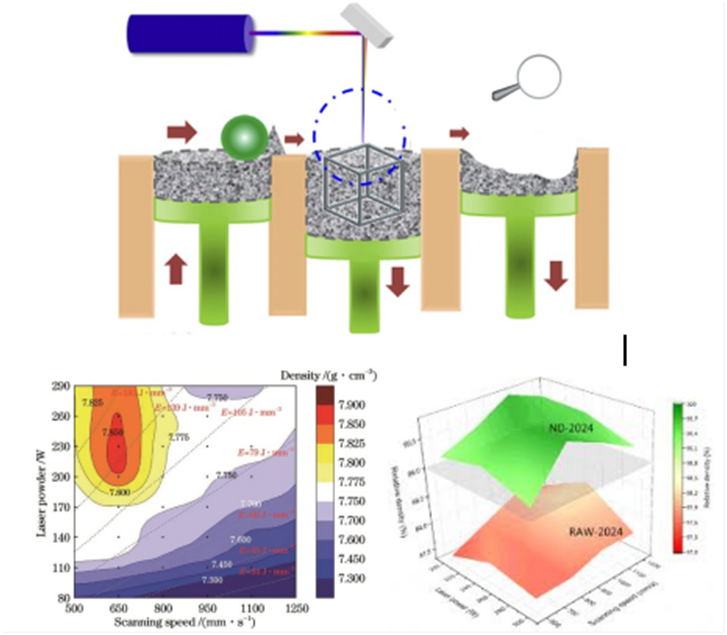

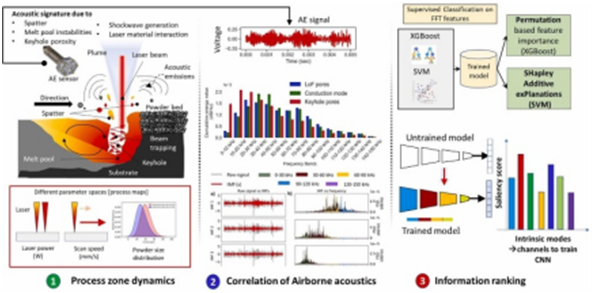

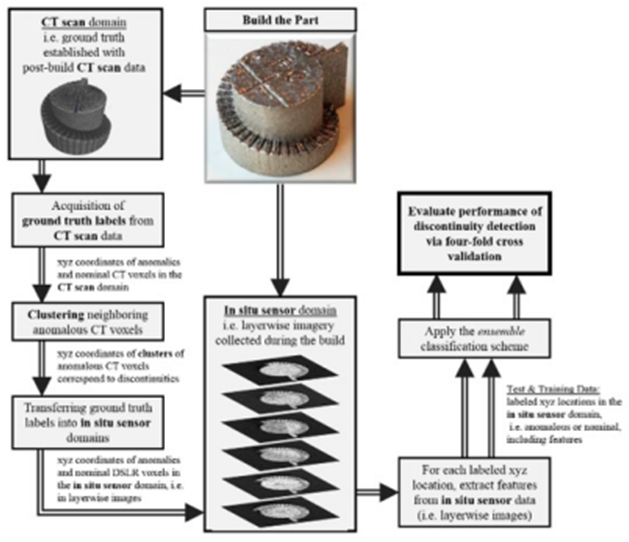

四、机器学习在增材制造实战应用

AI模型与增材制造应用基础

1.1增材制造工艺体系与关键挑战

·粉末床熔融技术:SLS(非金属)、SLM/EBM(金属)的激光/电子束-粉末相互作用机制

·定向能量沉积技术:LENS工艺的熔池动力学特性

·熔融沉积成型技术:FDM金属丝材的挤出-重熔行为

1.1.1增材制造过程稳定性挑战

·熔池不稳定性(飞溅、球化)

·层间热应力导致的变形与开裂

·粉末铺展均匀性与惰性气体流场扰动

1.1.2缺陷控制维度

·孔隙率与未熔合缺陷的形貌特征

·微观组织各向异性对力学性能的影响

·后处理(热等静压、热处理)对缺陷的修复机制1.2 AI模型架构与增材制造适配性

1.2.1 机器学习基础框架·监督学习(工艺参数-质量指标映射)

·无监督学习(缺陷模式聚类分析)

·强化学习(动态工艺参数调整)

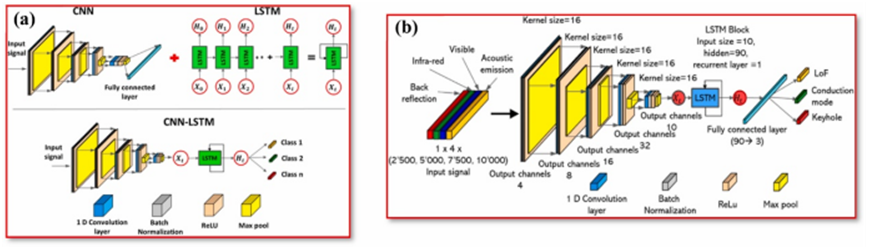

1.2.2 深度学习专项模型

·CNN用于熔池图像特征提取

·LSTM处理时序热历史数据

·GAN生成合成训练数据以弥补实验不足

1.3 工艺参数-缺陷关系的智能解析

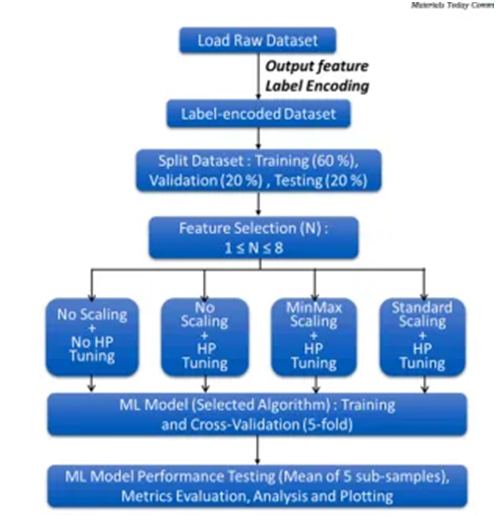

1.3.1 多算法密度预测对比实验

·输入参数:激光功率/扫描速度/层厚/预热温度

·算法池:支持向量机SVR,决策树DT,随机森林RF,高斯过程回归GPR,K-Nearest neighbors, KNN, 梯度下降Stochastic gradient descent, 多层感知器multi-layer perceptron, XGBOOST,人工神经网络ANN来研究选择性激光融化工艺制造的工艺参数与相对密度的关系,目的通过优化工艺参数提高零件的致密度。

·验证指标:R²分数、MAE、交叉验证稳定性

1.3.2 跨工艺迁移学习框架

·小样本条件下基于TL的模型泛化能力提升域适应算法解决设备差异性难题

机器学习驱动的Ti-6Al-4V合金SLM工艺优化

目标:通过经典机器学习算法预测激光功率(P)、扫描速度(v)、 hatch间距(h)对相对密度(ρ)的影响

1.4.1 环境配置与数据工程

1.4.2 工具链部署

·Python 3.8+环境配置(Anaconda推荐)·PyCharm工程结构:

·关键库安装:

1.4.3 数据预处理流程

·数据获取:从GitHub导入作者发布的SLM工艺数据集(含大约300组Ti-6Al-4V实验数据)

·异常值处理:

·特征工程:

1.4.4机器学习建模核心环节

1.4.5算法对比实验设计

1.4.6 结果可视化与工艺优化

1.4.7 评价指标体系

1.4.8 局限性讨论·材料批次差异的影响·多目标优化需求(密度 vs 残余应力)

可解释机器学习驱动的增材制造合金结构-性能解码

2.1 增材制造合金多尺度结构特征库

2.1.1 微观结构指纹

·晶粒(长径比/取向)的EBSD量化方法

·气孔/未熔合缺陷的CT扫描三维重构

2.1.2 介观结构网络

·晶界网络连通性分析

·相分布拓扑参数(α/β相占比、片层间距)

2.1.3 宏观结构特征

·沉积层带取向与力学各向异性

·表面粗糙度-力学性能关联性

2.2 可解释机器学习框架

2.2.1 算法选型与物理适配

2.2.2 可解释性评估与验证

2.3 物理场耦合策略

·热-力耦合场数据作为输入特征(温度梯度/冷却速率)

·晶体塑性有限元结果作为先验知识约束损失函数

2.4案例实战:微观组织-力学性能的智能关联分析

目标:通过机器学习建立Ti-6Al-4V的α相片层厚度→拉伸强度的定量关系

2.4.1 微观组织特征工程

2.4.2高精度图像数据库构建·数据来源:

2.4.3特征筛选策略·物理驱动筛选:基于Hall-Petch公式保留晶粒尺寸相关特征·数据驱动筛选:通过XGBoost特征重要性排序

2.4.4 机器学习建模核心

2.4.5 多算法对比实验

2.4.6 关键代码逻辑

2.4.7 可解释性分析

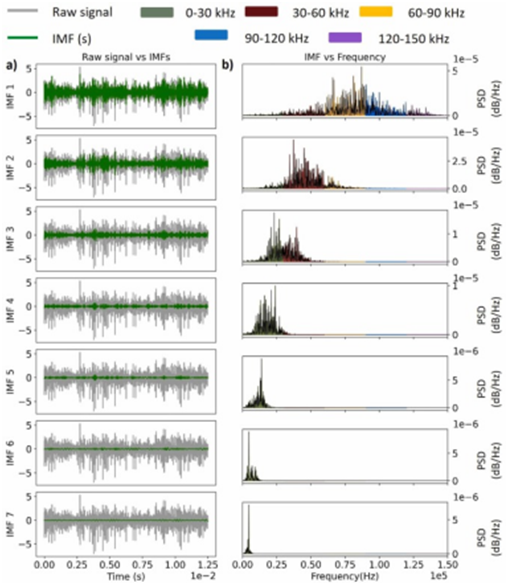

机器学习在增材制造过程监控与应用

3.1增材制造过程传感信号特征库

3.1.1 信号模态物理特性

• 声发射信号:裂纹/未熔合的特征频段(100-300kHz)

• 熔池光学信号:等离子体辐射强度与孔隙率关联• 红外热成像:层间温度梯度与残余应力映射3.1.2多传感器数据融合框架

• 时频域特征提取(小波变换/短时傅里叶变换)

• 跨模态特征对齐方法(动态时间规整算法)

3.2 异构数据分类算法

• 针对高频声学信号:1D-CNN时序特征提取架构• 多光谱光学信号:注意力机制增强的ResNet网络

3.3 案例实战:激光粉末床熔融过程缺陷溯源目标:建立声学-光学信号特征→缺陷类型(气孔/球化/裂纹)的分类模型

3.3.1 数据预处理

• 声学信号处理:

• 光学信号处理:

3.3.2 模型可解释性分析

• SHAP值分析

• 物理机理验证

3.3.3 系统集成演示

生成式AI驱动的增材制造工艺数字孪生

4.1生成式AI模型架构解析

4.1.1核心模型对比

• VAE:潜在空间连续性与工艺参数插值优势

• GAN:熔池形貌高保真生成能力(WGAN-GP解决模式崩溃)

• 衍生模型

·CycleGAN用于跨工艺参数域迁移(激光功率→扫描速度映射)

·StyleGAN2实现多尺度微观组织生成(α/β相分层控制)

4.2 增材制造专用模型设计

• 物理约束的损失函数设计:

·热传导方程约束熔池长宽比生成

·晶体取向统计匹配EBSD实测数据

·多模态输入架构

·工艺参数(功率/速度/层厚)作为Conditional GAN的输入条件

4.3熔池动力学数字孪生

• 基于pix2pixHD的工艺参数→熔池形貌端到端预测

• 时序生成模型(LSTM-GAN)预测层间热累积效应

4.4 微观组织逆向设计

• VAE潜在空间探索:力学性能→最优晶格结构反向推导6

• 对抗性生成网络实现气孔缺陷的对抗性修复

4.5案例实战:Ti-6Al-4V激光熔池生成系统目标:构建工艺参数(P, v)→熔池形貌的WGAN-GP生成模型

4.5.1 数据工程

• 仿真数据构建

4.5.2 模型开发核心

• 关键代码模块

•训练策略

4.5.3 生成质量评估体系

• 定量指标:

- FID分数:生成与仿真熔池的特征距离评估4

- 几何吻合度:熔池轮廓Hausdorff距离计算

• 物理验证:

- 生成熔池的热历史曲线与CFD仿真结果对比

多模态传感驱动的增材制造实时质量监控系统

5.1混合模型架构创新

5.1.1 时空特征融合架构

• CNN-LSTM-Attention三阶段处理流:

oCNN分支:处理X射线断层扫描(XCT)图像(空间特征提取)

oLSTM分支:分析声发射信号时序特征(裂纹扩展动力学建模)

oAttention机制:动态加权多传感器特征重要性

• 物理约束设计:

o热-声耦合损失函数(熔池振荡频率与声发射频谱匹配)

5.2 工业级缺陷分类系统

5.2.1 多尺度缺陷检测框架:

o宏观缺陷(气孔/未熔合):XCT+光学信号融合分类

o微观缺陷(微裂纹/析出相):EBSD+声发射信号协同分析

• 实时性优化:

o模型量化(FP16精度)实现<50ms单帧处理延迟

5.2.2跨模态数据融合技术

• 时间戳同步:X射线脉冲与声发射信号的相位锁定

• 空间配准:光学图像与XCT体数据的3D仿射变换

5.3 特征工程创新

5.3.1 声发射信号处理:

o改进MFCC特征提取(增加熔池振荡频段权重)o包络分析检测微裂纹萌发事件

5.3.2数据管道构建

• 多源数据采集:

- 同步触发协议设计(X射线脉冲与声发射采集时钟同步)

- 数据增强:工艺参数扰动下的缺陷模拟(功率±15%随机波动)

• 特征标准化:

- XCT灰度值归一化(Hounsfield单位转换)

- 声发射信号小波降噪(Symlets基函数优化)5.3核心模型实现与训练技巧

5.4.1混合模型架构:

5.4.2训练优化

- 渐进式训练策略:先独立训练单模态分支,再联合微调

- 对抗样本增强:FGSM攻击模拟传感器噪声

5.4工业验证体系

• 定量指标:

- 缺陷分类F1-score:XCT模态(0.92) vs 多模态融合(0.97)

- 实时性测试:平均延迟43ms(满足产线节拍要求)

• 物理验证:

- XCT断层扫描与金相切片的空间误差<25μm

- 声发射事件定位精度达±2mm

五、人工智能有限元仿真

深度学习算法理论与实践

1-Python安装与环境配置方法

2-张量(Tensor)的创建和常用方法

3-Python实现基本优化思想与最小二乘法

4-基于Pytorch的深度学习入门

5-单层神经网络

6-深层神经网络

7-神经网络的损失函数

8-基于Pythorch的神经网络构建

基于多尺度仿真与人工神经网络的复合材料实战应用

1. 多尺度技术背景及概念

1.1 多尺度技术发展

1.2 多尺度技术种类

1.3 多尺度技术实施方法

2. ABAQUS与Python二次开发

2.1 ABAQUS脚本概述

2.2ABAQUS二次开发的基础框架

2.3Python脚本接口

2.4CAE环境开发与用户子程序开发

2.5 Python语言介绍

2.6ABAQUS脚本编写

2.7 含骨料/纤维RVE模型二次开发

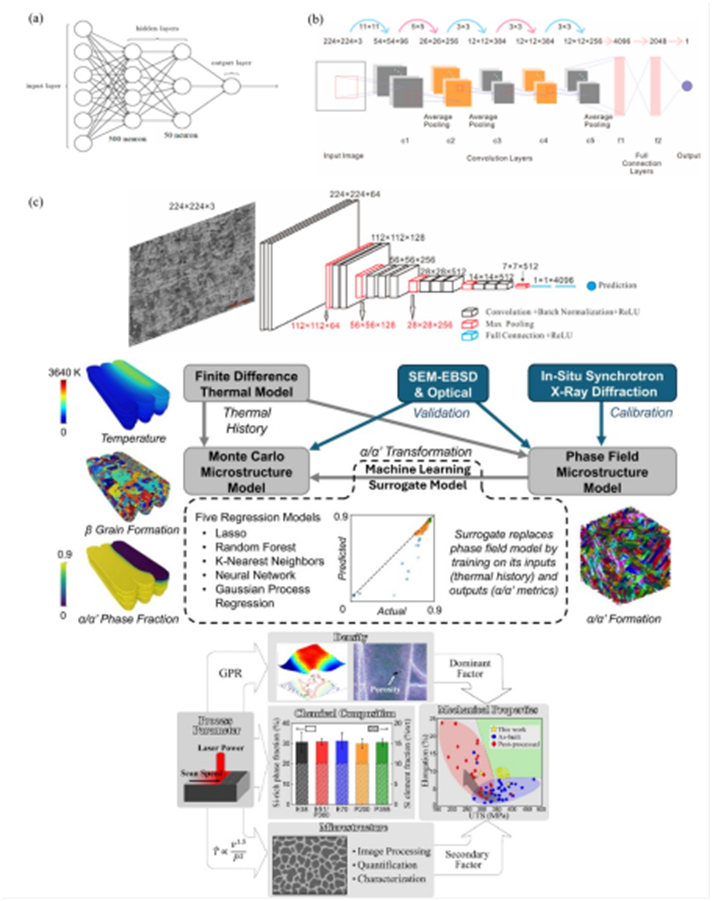

3. 人工神经网络驱动的多尺度FE2方法

3.1 协同多尺度FE2方法技术详解

3.2 基于UMAT的ABAQUS协同多尺度方法概述

3.3 基于UMAT的ABAQUS协同多尺度仿真实施

3.4 ANN网络架构介绍

3.5 基于ANN的高保真FE2驱动的先进FE2方法的具体框架

4.基于深度学习的金属材料力学性能预测与结构-性能关系建模实战应用

4.1. 卷积神经网络与材料性能预测

4.2CNN基本原理与材料科学应用系统介绍卷积神经网络的核心概念和基础理论

4.3 微观结构图像的CNN特征提取详细讲解如何设计适合材料微观结构特性的CNN模型

4.4基于CNN的多相材料力学性能预测系统介绍基于CNN的力学性能预测方法

5. 深度神经网络模型优化与实现

5.1 多管道Siamese网络结构设计详细介绍Siamese网络结构在材料科学中的应用

5.2 损失函数设计与训练策略深入探讨适合材料性能预测的损失函数设计

5.3基于TensorFlow的多相金属材料强度预测实现通过完整的TensorFlow代码示例,

5.4CPFE-DNN集成预测增材制造不锈钢性能详细介绍CPFE-DNN集成方法在增材制造不锈钢性能预测中的应用

基于无应力数据的深度学习超弹性材料实战应用

1. 超弹性材料力学行为分析

1.1 Hyperelastic材料力学行为

1.2 Hyperelastic材料仿真分析(案例)

2. 输入凸神经网络(ICNN)

2.1 ICNN技术介绍

2.2 ICNN技术具体实施及讲解(案例)

3. 无监督深度学习超弹性本构定律

3.1 问题设定

3.2 从逐点数据近似位移场

3.3 基于神经网络的本构模型

3.4 无监督学习的本构模型

4. 数值基准

4.1 数据生成

4.2 数据模型精度、泛化和FEM部署

基于物理约束人工神经网络架构实现材料本构的重构实战应用

1. 物理约束相关理论

1.1 变形映射

1.2 变形梯度

1.3 Cauchy-Green变形张量

2. 神经网络中物理信息概述

2.1 物理合理性限制

3. 物理约束在神经网络模型中的应用与实现

3.1 纯数据驱动的神经网络模型构建(案例)

3.2 能量驱动的神经网络模型构建(案例)

3.3 基于PDE的神经网络模型构建(案例)

4. 基于物理信息的神经网络架构与仿真技术融合

4.1 UANISOHYPER_INV人工神经网络本构子程序

4.2 基于物理信息的人工神经网络与仿真技术融合

4.3神经网络模型与传统数值模拟方法的融合策略

5.基于卷积神经网络的金属缺陷检测系统设计与实现实战应用

5.1经典CNN模型解析

5.2深度CNN设计与优化

5.3基于分类的缺陷检测方法

5.4基于分割的缺陷定位技术

5.5Bagging、Boosting、Stacking等集成方法在缺陷检测中的应用

基于递归神经网络的两相高温合金多尺度损伤建模实战应用

1. 基于均质化的多尺度建模

1.1相场的两相合金生成策略

1.2Abaqus的均匀化计算方法

2. 耦合损伤的晶体塑性有限元建模

2.1晶体塑性有限元基本理论与框架,有限元UMAT实施策略,切线系数法隐式应力积分,滑移系损伤建模。

3. 时序多尺度模拟与数据集构建

3.1批量多尺度有限元仿真技巧

3.2建立神经网络可识别的本构行为数据集

3.3对比FCNN,RNN,LSTM等网络方法在循环塑性行为建模中的优劣。

4智晶体塑性本构建模

4.1在本构建模中物理信息的融合机制与方法

4.2晶体塑性滑移变形的网络架构设计。

5.微观组织张量化描述及其智能重要性评估

5.1两相材料微结构张量化描述方法

5.2,通过人工智能识别关键的微结构参量。

6.多轴载荷下的模型表现研究

6.1多轴载荷下对不同形态两相微结构的力学行为预测研究,

6.2多轴载荷下的合金损伤机制